В файле robots.txt указываются правила индексирования страниц сайта для роботов разных поисковых систем. Файл robots.txt в Тильде генерируется автоматически. Он доступен по следующему адресу:

https://mysite.com/robots.txt (где mysite.com – ваш домен, http/https и www/без www зависит от ваших настроек)

Вручную внести изменения в файл нет возможности. Это можно сделать только через Настройки сайта или через Настройки страницы.

https://mysite.com/robots.txt (где mysite.com – ваш домен, http/https и www/без www зависит от ваших настроек)

Вручную внести изменения в файл нет возможности. Это можно сделать только через Настройки сайта или через Настройки страницы.

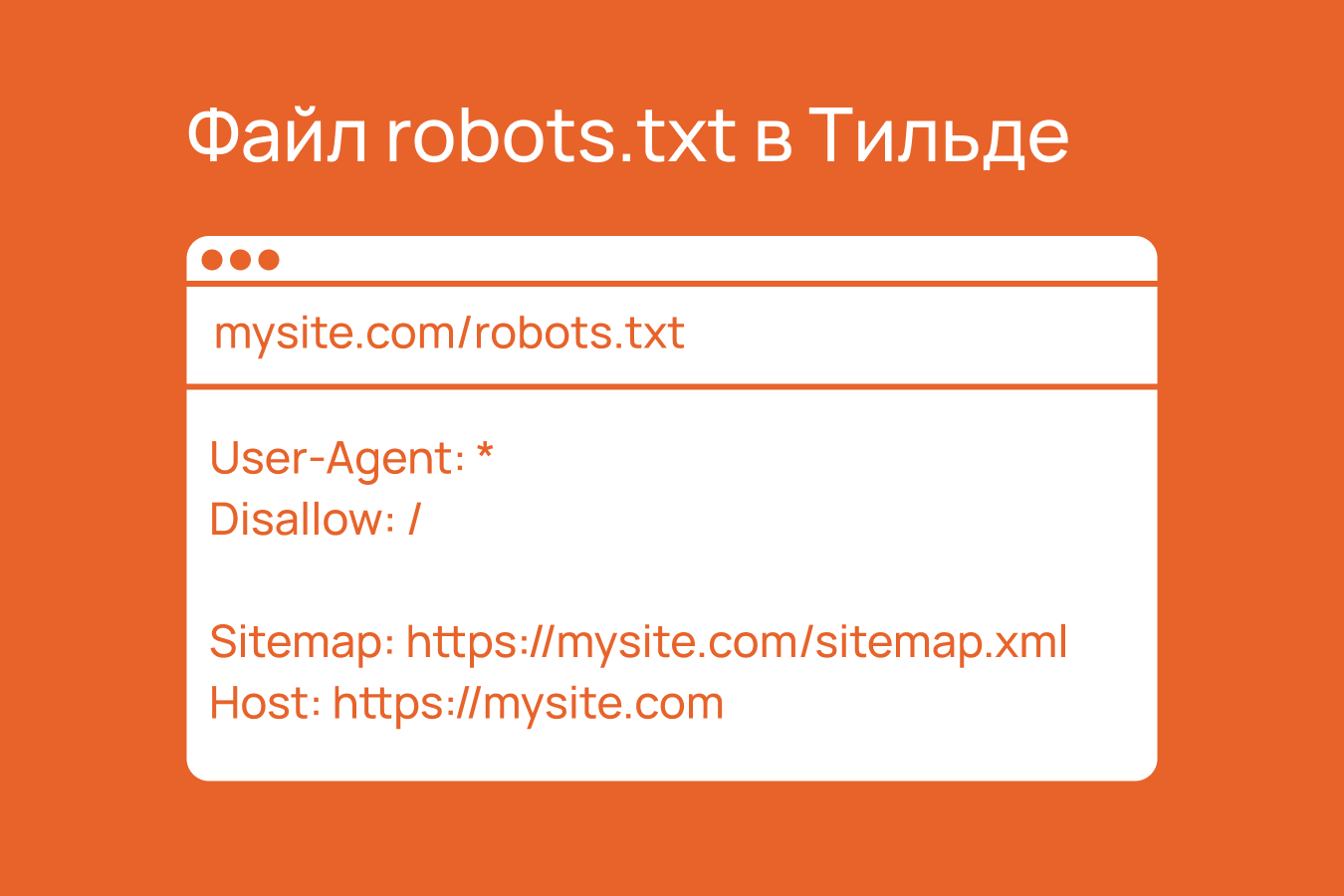

Структура файла robots.txt

По умолчанию файл формируется сразу для всех поисковых роботов, поэтому правила прописываются для «User-Agent: *». Если вы указали значения для директивы Clean-param, то в файле ещё будут отдельные правила для роботов Яндекса – «User-Agent: Yandex».

В директиве «Disallow» прописывается, какие страницы не должны индексироваться поисковиками. Некоторые страницы по умолчанию закрыты от индексации, другие вы можете закрыть самостоятельно. Подробнее об этом будет далее в этой статье. В конце всегда будет пустой «Disallow», это корректно, он не мешает индексации сайта.

Если добавлена директива «Clean-param», она будет в «User-Agent: Yandex» после всех директив «Disallow».

Далее указываются ссылки на файлы Sitemap (в них содержатся все ссылки на страницы, которые должны быть проиндексированы). В зависимости от того, включены модули Каталог и Потоки или нет, в robots.txt могут быть указаны от одной до трёх ссылок:

В конце идёт строка с директивой «Host». В ней указывается основной URL сайта (с учётом http/https и www), по которому должен индексироваться сайт. Изменить наличие http/https и www в каноническом адресе можно в Настройках сайта → SEO → Определение основного адреса сайта в мета-файлах.

Если добавлена директива «Clean-param», она будет в «User-Agent: Yandex» после всех директив «Disallow».

Далее указываются ссылки на файлы Sitemap (в них содержатся все ссылки на страницы, которые должны быть проиндексированы). В зависимости от того, включены модули Каталог и Потоки или нет, в robots.txt могут быть указаны от одной до трёх ссылок:

- https://mysite.com/sitemap.xml (файл с основными страницами сайта);

- https://mysite.com/sitemap-store.xml (файл со страницами товаров из модуля Каталог);

- https://mysite.com/sitemap-feeds.xml (файл со страницами постов из модуля Потоки),

В конце идёт строка с директивой «Host». В ней указывается основной URL сайта (с учётом http/https и www), по которому должен индексироваться сайт. Изменить наличие http/https и www в каноническом адресе можно в Настройках сайта → SEO → Определение основного адреса сайта в мета-файлах.

Как в Тильде закрыть страницу от индексации

Как было указано ранее, некоторые страницы по умолчанию закрыты от индексации:

Автоматически закрываются от индексации установленные Header (шапка) и Footer (подвал) сайта, а также страница 404.

Чтобы закрыть от индексации страницу, перейдите в Настройки страницы → SEO → установите галочку возле опции «Запретить поисковикам индексировать эту страницу». Запрет пропишется как для указанного вами адреса страницы, так и для системного адреса (вида /page999999.html).

- адреса с /tilda/ – это ссылки на виртуальные страницы для настройки целей в системах аналитики;

- /*_escaped_fragment_* – такой фрагмент использовался когда-то в модуле Каталог;

- адреса с /members/ – это ссылки на страницы из личного кабинета на вашем сайте (эти ссылки появляются в файле, когда вы активируете личный кабинет на сайте).

Автоматически закрываются от индексации установленные Header (шапка) и Footer (подвал) сайта, а также страница 404.

Чтобы закрыть от индексации страницу, перейдите в Настройки страницы → SEO → установите галочку возле опции «Запретить поисковикам индексировать эту страницу». Запрет пропишется как для указанного вами адреса страницы, так и для системного адреса (вида /page999999.html).

Обращаем ваше внимание, что если вы закроете от индексации, например, страницу /contacts, то от индексации будут закрыты и все другие страницы, адрес которых начинается с /contacts (например, /contacts-msk или /contacts-spb).

В некоторых случаях поисковики могут игнорировать канонический адрес и индексировать системный адрес (вида /page999999.html). В этом случае можно попробовать поступить следующим образом. Создайте новую страницу на сайте, укажите ей адрес /page и закройте от индексации. В таком случае будут закрыты от индексации все системные адреса, поскольку они начинаются с /page. Но тогда проверьте, чтобы у вас у всех страниц были указаны свои адреса (а не системные).

Чтобы закрыть от индексации отдельный пост в модуле Потоки, в админке потока перейдите в карточку нужного поста → Соц. сети и SEO → установите галочку возле опции «Запретить поисковикам индексировать эту страницу». В файле robots.txt запрета не будет, но в коде страницы поста в метатеге «robots» будет указано «noindex». Это покажет поисковым роботам, что пост не следует индексировать.

В некоторых случаях поисковики могут игнорировать канонический адрес и индексировать системный адрес (вида /page999999.html). В этом случае можно попробовать поступить следующим образом. Создайте новую страницу на сайте, укажите ей адрес /page и закройте от индексации. В таком случае будут закрыты от индексации все системные адреса, поскольку они начинаются с /page. Но тогда проверьте, чтобы у вас у всех страниц были указаны свои адреса (а не системные).

Чтобы закрыть от индексации отдельный пост в модуле Потоки, в админке потока перейдите в карточку нужного поста → Соц. сети и SEO → установите галочку возле опции «Запретить поисковикам индексировать эту страницу». В файле robots.txt запрета не будет, но в коде страницы поста в метатеге «robots» будет указано «noindex». Это покажет поисковым роботам, что пост не следует индексировать.

Отдельные страницы товаров из модуля Каталог закрыть от индексации, к сожалению, нет возможности (как это реализовано для постов из модуля Потоки). В настройках каталога можно отключить генерацию файла Sitemap для каталога, но это не запретит поисковикам проиндексировать товары, если страницы всё же будут найдены. Единственный вариант – закрыть от индексации страницу, к которой привязаны товары. Например, все товары каталога выведены на странице /catalog, тогда в адресе всех страниц товаров будет фрагмент /catalog. Можно закрыть от индексации страницу /catalog, тогда будут закрыты от индексации и все страницы товаров, в адресе которых есть фрагмент /catalog.

Как в Тильде закрыть от индексации весь сайт

Если вы хотите закрыть весь сайт от индексации, перейдите в Настройки сайта → SEO → Запрет индексации → установите галочку возле опции «Запретить поисковикам индексировать этот сайт». В файле robots.txt для всех User-Agent пропишется «Disallow: /».

Такое же правило автоматически прописывается для системных адресов с tilda.ws, когда вы подключаете к сайту свой домен, чтобы сайт индексировался именно по вашему домену.

Ещё один вариант убрать все страницы сайта из поиска – установить логин и пароль для входа на сайт. Настройки сайта → Ограничить доступ → Ограничить доступ к опубликованным страницам → Логин/Пароль. Поисковые роботы не смогут попасть на страницы сайта, и поэтому не смогут их проиндексировать.

Ещё один вариант убрать все страницы сайта из поиска – установить логин и пароль для входа на сайт. Настройки сайта → Ограничить доступ → Ограничить доступ к опубликованным страницам → Логин/Пароль. Поисковые роботы не смогут попасть на страницы сайта, и поэтому не смогут их проиндексировать.